Victor Etxebarria Ecenarro, Universidad del País Vasco / Euskal Herriko Unibertsitatea

En los últimos años el término inteligencia artificial y todo lo que tiene que ver con ello está adquiriendo un gran protagonismo y sobredimensionamiento. La expresión inteligencia artificial está siendo abusada y utilizada de forma básicamente incorrecta diariamente y en múltiples ámbitos cotidianos, desde el político al empresarial.

¿Existen realmente máquinas inteligentes, similares a las personas? Si respondemos a esta pregunta con cierto rigor, desde las bases de las ciencias fundamentales que soportan los pilares de este área –matemáticas y física–, la respuesta es que no. Y muchos científicos conjeturan y argumentan seriamente que probablemente nunca existirán.

Computar no es lo mismo que pensar

Partamos de las áreas de conocimiento adyacentes a las matemáticas y la física que se expandieron desde los años 30 y 40 del siglo XX, como la ciencia de la computación, la electrónica, la automática o el propio área de inteligencia artificial.

En el año 1937 vieron la luz dos publicaciones científicas de enorme importancia: la primera, Sobre los números computables, con una aplicación al Entscheidungsproblem del matemático Alan Turing, y la segunda, Análisis simbólico de relés y circuitos de conmutación, del matemático e ingeniero electrónico Claude Shannon. Estos trabajos fundaron la forma inicial de crear máquinas electrónicas capaces de computar, manejar información y manipular símbolos mediante programación algorítmica.

Sin embargo, la inteligencia artificial, entendida como aquella que pretende replicar capacidades intelectuales similares a animales o personas (llamada inteligencia general o inteligencia fuerte) no se ha demostrado en absoluto. Esto es: no hay evidencia ni matemática, ni física, ni se conoce la existencia de ningún prototipo equivalente a las capacidades pensantes de un cerebro humano.

Decisión vs. elección

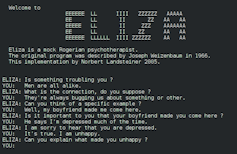

En 1966 el matemático y profesor de Ciencias de la Computación en el Instituto Tecnológico de Massachusetts (MIT) Joseph Weizenbaum creó en su laboratorio un programa llamado ELIZA capaz de realizar procesamiento de lenguaje natural.

Esta sencilla herramienta reconocía palabras clave en las frases del usuario para elegir una frase modelo de su base de datos con la que contestar.

ELIZA era capaz de entablar una conversación con seres humanos simulando a una psicóloga empática. Weizenbaum modeló su estilo de conversación como preguntas abiertas para animar a los pacientes a comunicarse más eficazmente con la terapeuta, y le sorprendió que su programa fuera tomado en serio por muchos usuarios.

A la vista de que gran número de admiradores consideraron el programa como verdadero precursor de las máquinas pensantes, el propio autor se vio obligado a dejar claro que consideraba esta interpretación totalmente errónea e intentó vehementemente corregir en sus intervenciones posteriores estas ideas.

Entre otros muchos escritos, Weizenbaum publicó en 1976 el libro El poder informático y la razón humana: del juicio al cálculo. Con él trataba de explicar al público en general su trabajo y sus consecuencias desde la filosofía de la ciencia, sin incluir turbadoras fórmulas matemáticas en el texto.

En el libro, el autor distingue entre las capacidades de los computadores y el razonamiento humano, y establece una distinción crucial entre decidir y elegir. Lo mismo que en la automática la decisión y control de un proceso industrial se implementa con un circuito o un computador como controlador programado de dicho proceso, Weizenbaum explica que decidir es una actividad computacional, algo que en última instancia puede programarse y, sin embargo, la elección es el producto del juicio, no del cálculo.

El papel de la mecánica cuántica

En 1989, el físico, matemático y Premio Nobel en el año 2020 Roger Penrose publicó su influyente libro La nueva mente del emperador en el que demuestra que el pensamiento humano no es básicamente algorítmico.

A caballo entre las matemáticas, la filosofía de la ciencia y la física, el texto incorpora tanto demostraciones matemáticas como ilustradas discusiones de los famosos exámenes de inteligencia (como el test de Turing y el experimento de la habitación china). Además conjetura la posible necesidad de las leyes de la mecánica cuántica para poder explicar correctamente nuestras mentes.

La obra fue devastadora para la tradicional inteligencia artificial fuerte. Inspiró contestaciones de múltiples autores en diversas áreas de conocimiento, pero sus tesis no pudieron ser refutadas convincentemente.

Penrose avanzó aún más en sus ideas con el segundo de sus libros sobre la conciencia humana, publicado en 1994: Las sombras de la mente. En él incluye una propuesta detallada sobre cómo podrían implementarse esos procesos cuánticos en el cerebro.

Las nuevas conjeturas, en colaboración con la biología y la neurociencia médica sugeridas por Penrose, incluyen en particular el citoesqueleto de las neuronas. En concreto los microtúbulos, importantes componentes del citoesqueleto, son lugares plausibles para el procesamiento cuántico y, en última instancia, para la conciencia.

Estas ideas pueden perfectamente ser incorrectas, tal y como el propio Penrose argumenta. Muchos investigadores multidisciplinares en estos campos intentaron refutar parte de estas propuestas, pero actualmente siguen en vigor.

Sin inteligencia artificial a la vista

Desde un punto de vista global, sabemos que se han estudiado múltiples enfoques desde hace décadas para tratar de expandir la inteligencia artificial. Las redes neuronales, los sistemas expertos, la lógica fuzzy y en los últimos tiempos el deep learning y el big data han dado lugar a útiles herramientas para resolver problemas con fines específicos.

Estas herramientas pueden ser impresionantes, pero debemos tener muy claro que no nos hemos acercado al desarrollo de la inteligencia artificial general. La llamada inteligencia débil (o inteligencia estrecha) corresponde con las aplicaciones que hoy tenemos, pero las afirmaciones exageradas sobre sus éxitos, de hecho, dañan la reputación de la inteligencia artificial como ciencia.

En más de ochenta años de investigación en este área no se ha producido ninguna prueba firme de niveles humanos de inteligencia artificial general. Sabemos que los circuitos artificiales son incapaces de modelar los sistemas nerviosos incluso de los invertebrados más simples. Aún con computadores muy rápidos y con enormes bases de datos, confiar en que el razonamiento, la inteligencia y la conciencia surjan de alguna manera simplemente aumentando más y más la complejidad no parece más que un camino sin salida.

Las herramientas informáticas son muy útiles, pero aunque una máquina gane a los ajedrecistas profesionales o sea capaz de proponer un recurso legal buscando jurisprudencia en su gran base de datos, no es una máquina pensante. Es importante no banalizar, diferenciar entre herramientas tecnológicas y entes inteligentes, así como dejar a la ciencia seguir trabajando con rigor en esta apasionante materia.![]()

Victor Etxebarria Ecenarro, Catedrático, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Lea el original.